AI Act und ChatGPT – Regulierung der Nutzung von KI in Finanzinstituten

Die Diskussion um den Nutzen und die Risiken Künstlicher Intelligenz sowie deren Nutzung im privaten oder beruflichen Umfeld hat sich in den letzten Monaten deutlich verstärkt. Insbesondere durch den einfachen und aktuell noch kostenfreien Zugang zu ChatGPT als mächtigen Textgenerator wurden etliche Beispiele einer Nutzung veröffentlicht und überaus intensiv in Tageszeitungen oder im Frühstücksfernsehen populär ausgebreitet. Insbesondere negativ bewertete ChatGPT-Beispiele wie etwa Chatverläufe mit Aufforderungen zu kriminellen Handlungen oder auch Ergebnistexte mit offensichtlich nicht aktuellen Fakten haben die möglichen Risiken in der Diskussion an Wichtigkeit gewinnen lassen. Allgemein war aber viel Verwirrung und Unwissen erkennbar.

Parallel dazu beschäftigt sich das Europäische Parlament schon seit längerem mit der Entwicklung Künstlicher Intelligenz unter dem Primat einer menschzentrierten und Ethik-basierten Sichtweise. Ein erster Entwurf für den Artificial Intelligence Act (kurz AI Act) als Ergänzung der bestehenden Regelungen zur Datenschutzgrundverordnung wurde vorgelegt und am 14.06.2023 verabschiedet; nun beginnen die weiteren Abstimmungen u. a. mit der EU-Kommission. Ziel ist es, branchenübergreifend Regularien zu schaffen, um die Nutzung dieser Technologien transparent und rechtssicher zu gestalten und die Risiken adäquat zu managen.

Somit ist das Thema endgültig auch in der Finanzwirtschaft angekommen. Wurden bisher schon erste Anwendungen mit eher regelbasierten AI-Technologien wie z. B. Kreditscoring oder Geldwäscheüberwachung eingesetzt, so werden durch die anstehenden EU-Regularien neue Rahmenbedingungen entstehen. Parallel dazu werden Mitarbeitende selbstständig Nutzungsmöglichkeiten eines ChatGPT erproben und dann auch ggf. unabgestimmt in Geschäftsprozessen einsetzen. Sowohl auf den bald geltenden Rahmen „von oben“ als auch die schon heute laufenden Initiativen „von unten“ müssen die Finanzinstitute – wie andere Branchen auch – schnell Antworten finden.

Wesentliche Inhalte des Artificial Intelligence Act

Die übergeordnete Zielsetzung des EU-Parlaments berücksichtigt die Perspektiven von Nutzern und Anbietern gleichermaßen. AI-Systeme sollen von Menschen überwachbar sein und überwacht werden, sollen sicher und transparent gestaltet sein, mit erklärbaren und nachvollziehbaren Ergebnissen ohne diskriminierende Inhalte, und dazu noch umweltfreundlich.

Weiterhin wird eine allgemeingültige Definition von AI angestrebt, die technologieneutral und damit zukunftsfähig ist.

Zu beachten ist zunächst die risikobasierte Klassifizierung von AI-Nutzungen, die gleichermaßen für Nutzer und Anbieter Geltung hat (Beispiele nach jetzigem Stand der Diskussion im Parlament). Je nach Klassifizierung sind entsprechende Auflagen zum Einsatz zu befolgen:

- Verbotene AI-Nutzung/inakzeptables Risiko:

- Einsatz manipulativer Techniken

- Biometrische Fernidentifizierungssysteme in „Echtzeit“ in öffentlich zugänglichen Räumen

- Willkürliches Auslesen biometrischer Daten aus sozialen Medien oder CCTV-Aufnahmen zur Erstellung von Gesichtserkennungsdatenbanken

- Regulierte AI-Nutzung/hohes Risiko:

- Systeme mit Möglichkeit der Beeinträchtigung von Gesundheit, persönlicher Sicherheit, fundamentalen Bürgerrechten oder der Umwelt

- Beeinflussung von Wahlen in politischen Kampagnen

- Empfehlungssysteme sozialer Netzwerke

- Transparente AI-Nutzung/niedriges Risiko:

Systeme mit dieser Klassifizierung sind unter Beachtung von Vorgaben einsetzbar; dies umfasst im Wesentlichen Systeme (wie etwa auch ChatGPT) mit einem zugrunde liegenden „Foundation Model“. So müssen die Ergebnisse mindestens in der direkten Interaktion mit Nutzern als von AI erzeugt kenntlich gemacht sein und gesetzkonforme Ergebnisse erzeugen, also z. B. keine illegalen Inhalte als Verletzung von Rechtsnormen oder Copyrights. Die zum Trainieren der benutzen Modell verwendeten Daten sind ebenfalls transparent zu machen, wobei hierbei die Umsetzbarkeit Fragen aufwirft. Ergänzend hierzu wären solche Systeme vor Nutzungsfreigabe durch staatliche Stellen zu testen.

Insgesamt wird die Technologie der Künstlichen Intelligenz und deren Anwendung in absehbarer Zeit deutlich reglementierter werden; die Zeit des freien und in Teilen auch unausgegorenen „Werfens auf den Markt“ dürfte dann zumindest in der EU vorbei sein. Verstöße gegen die Verordnung können mit hohen Strafzahlungen sanktioniert werden.

Auswirkungen des AI Act auf Finanzinstitute

Zunächst ist der Einsatz von AI der höchsten Risikoklassifizierung nicht erlaubt. Dies ist streng zu kontrollieren. Allerdings erscheinen die Beispiele mit inakzeptablem Risiko von vorneherein keine wesentliche Relevanz für Finanzinstitute zu haben.

Fokus sollte auf den Regelungen zu den AI-Systemen mit hohem Risiko liegen, denn hier können aktuelle oder auch absehbar künftige Anwendungsgebiete in Finanzinstituten liegen. Beispiele hierfür können das schon erwähnte Kreditscoring mit einer noch stärkeren Beachtung nichtdiskriminierender transparenter Entscheidungen sein, aber auch die Bewertung der Leistungen von Mitarbeitenden anhand von Kennzahlen oder die Analyse von Bewerbungen potenzieller Mitarbeitender.

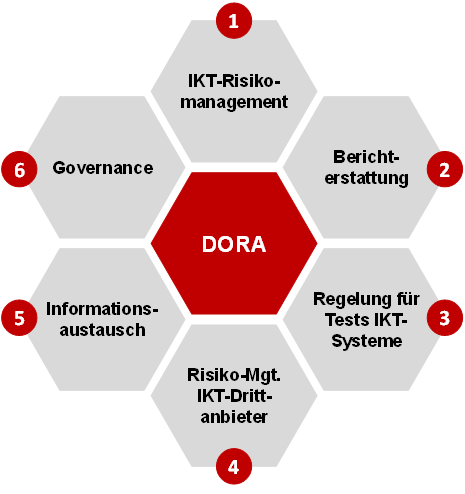

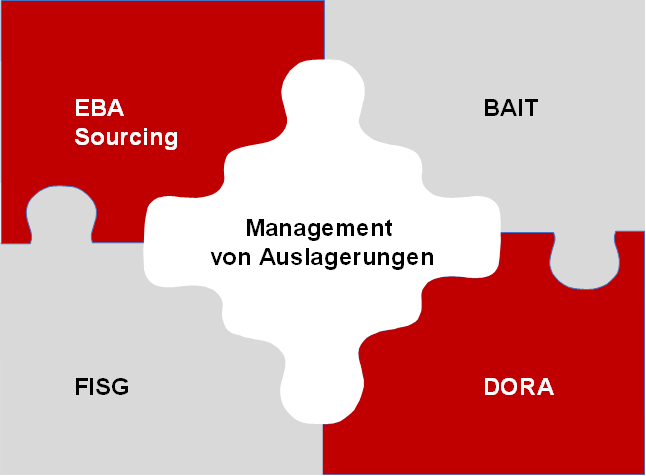

Die absehbaren Auswirkungen bestehen (neben möglichen Strafen bei Verstößen) insbesondere in den notwendigen technischen und organisatorischen Vorkehrungen, die in Gänze noch nicht vollständig erkennbar sind. Es dürfte aber zu erwarten sein, dass die EU-Regularien in branchenspezifischen Vorgaben wie etwa der BAIT oder in allgemeiner Form in die DSGVO einfließen werden, und dies eher früher als später. Wir werden dies zu einem späteren Zeitpunkt vertiefen.

Bei Systemen, die auf einem Foundation Model basieren, dürfte die wesentliche Herausforderung daran liegen, die Transparenz zum Pretrainingsinhalt zu erlangen, diese zu bewerten und auch dem Nutzer in verständlicher Form bereitzustellen. Beispielhaft hierfür ist die Datenlage des Pretrainings für ChatGPT, das dem Vernehmen nach aktuell in Teilen zwischen 5 und 18 Monaten Verzögerung aufweist und entsprechend alte Fakten verwendet.

Einsatzmöglichkeiten der transparenten AI-Nutzung am Beispiel ChatGPT

Dem schon angesprochenen „Druck von unten“ durch die Mitarbeitenden der Finanzinstitute an ihre Arbeitgebenden ist konstruktiv zu begegnen. Aus unserer Sicht könnten sich für das prominente Beispiel ChatGPT Einsatzmöglichkeiten als simple Arbeitserleichterung anbieten. Beispiele:

- Input zur Strukturierung von Fragestellungen, z. B. Gliederungen für Konzepte oder als Mindmaps

- Allgemeine Textblöcke zu einem Stichwort erzeugen

- Einfache Programmierung in der IT, d. h. kleinere Programmteile oder Makros/Skripte in der entsprechenden „Sprache“

- Erzeugung von strukturierten Testdaten (z. B. Kunden mit Vertragsdaten und Adressen) für den Aufbau von Testdatenbanken oder Schnittstellentests

- Vorhandene Texte analysieren und zusammenfassen lassen

- Qualität von Anforderungen prüfen lassen

Die folgenden Beispiele wurden von ChatGPT selbst vorgeschlagen auf die Frage hin, welche Einsatzmöglichkeiten des Tools bei Banken bestehen:

- Analyse von Kundenfeedback und ‑bewertungen, um Trends und Muster zu erkennen und Verbesserungsvorschläge abzuleiten.

- Automatisierte Erstellung von Berichten und Analysen, um Finanzdaten zu interpretieren und Managemententscheidungen zu erleichtern.

- Übersetzung von Finanzdokumenten und ‑berichten in verschiedene Sprachen, um die Kommunikation mit internationalen Kunden zu erleichtern.

- Automatisierte Erstellung von Finanzprognosen und Risikobewertungen zur Unterstützung des Risikomanagements und der finanziellen Planung.

Wesentliches Problem der syntaktisch-semantisch hergeleiteten Ergebnisse mit ChatGPT ist und bleibt aber, dass keine Verbindung mit Fakten stattfindet. Nur wenn das Trainingsmaterial stets aktuell und permanent als sachlich korrekt geprüft wäre, dann wären die erzeugten Ergebnisse auch inhaltlich verlässlich.

Folglich wären aktuell keine guten Einsatzgebiete z. B. die Erzeugung batchgetriebener Massentexte oder fallabschließende Callcenter-Robots.

Fokus bleibt mit ChatGPT die Erleichterung in der Outputerzeugung. Es findet kein Ersatz von Kompetenz, Erfahrung und Sorgfalt statt. Jedes Ergebnis einer Abfrage muss mit Sinn und Verstand geprüft, ggf. iterativ verbessert und ggf. durch den Nutzer mit weiteren aktuellen Fakten angereichert werden.

Hinweise in der Verwendung zu ChatGPT

Wenn nun die Nutzung eines ChatGPT auch im dienstlichen Umfeld eines Finanzinstituts ermöglicht werden soll, dann wären den Nutzern – auch zur Vermeidung von Arbeitszeitverschwendung – am besten geeignete Hinweise oder sogar Schulungen anzubieten. Da die Hantierung ein interaktives Nachhaken ermöglicht und somit die Nutzung von ChatGPT den Charakter einer Unterhaltung hat, ist ein gutes Verständnis sowohl über die Limitierungen als auch über eine effiziente Unterhaltungsführung erforderlich.

Zu vermittelnde Inhalte hierzu könnten sein:

- Je spezifischer die Angaben im Prompt (also der Eingabe des Nutzers) zum Kontext, zur Art des Zielresultats und zu Länge, Format oder Stil sind, desto besser sind die Ergebnisse.

- Es können verschiedene Ergebnisformate angegeben werden, so dass das Ergebnis direkt in andere Tools (z. B. per Copy/Paste) übernommen werden kann.

- Die einzelnen Teile einer Unterhaltung bestehen aus sogenannten Tokens. Ein Token kann beispielsweise ein Wort, ein Satzzeichen oder eine Sequenz von Buchstaben der vorhergesagten Antwort sein. Je nach Ausbaustufe besteht eine Längenbegrenzung zwischen 4.000 und 8.000 Token, was den Umfang der Unterhaltungsinhalte limitiert.

- Es ist eine Übersetzungsfunktion integriert. Je nach fachlichem Inhalt kann es zielführend sein, die Anfrage auf Englisch (als Hauptsprache des erfolgten Pretrainings von ChatGPT) zu stellen und erst nachträglich die Übersetzung in Deutsch zu verlangen.

- Die Herleitung von Texten kann Top-Down erfolgen, also von der thematischen Gliederung hin zu einer immer weiter ausgefeilteren Detailbearbeitung eines Unterthemas, ggf. in einem separaten Chatverlauf.

Was bei allen Informationen gilt, die im Internet eingegeben werden, gilt natürlich auch für ChatGPT. Die Daten der Eingabe in den Prompts werden gespeichert und ggf. auch genutzt, um die Wissensbasis zu erweitern. Es ist also nicht erlaubt, vertrauliche Informationen des Finanzinstituts in den Prompts zu verwenden. Da dies technisch nicht überwacht werden kann, ist hierfür eine organisatorische Lösung erforderlich.

Das System bietet auch ein „Opt-Out“ der Speicherung an, das aber durch den Nutzer in seinem Account unter Settings/Data Controls/Chat history & training auszuwählen ist.

Expertise bankon Management Consulting

Die Expertise der bankon-Berater aus mehr als fünfzehn Jahren Erfahrung mit Projekten im Kontext IT-Management (ITIL), Providermanagement, IT-Services sichert praxiserprobtes Wissen. Umfangreiche Kenntnis von Organisations- und Providerstrukturen, Prozessen und IT-Systemen deutscher Banken und Sparkassen sowie der aktuellen technologischen Entwicklungen gewährleisten den erforderlichen fachlichen und technischen Hintergrund.

Erfahrungen aus der Vorbereitung, Begleitung und Nachbereitung von Prüfungen der Bankenaufsicht ergänzen diese Praxiserfahrung um regulatorische Kompetenz.

Nutzen Sie unsere umfangreichen Erfahrungen und sprechen Sie mit uns:

bankon Management Consulting GmbH & Co. KG

Max-Planck-Str. 8

85609 Aschheim/München

Tel.: (089) 99 90 97 90

Fax: (089) 99 90 97 99

Web: https://www.bankon.de

E‑Mail: research@bankon.de

Die Bilder in diesem Artikel wurden mit der AI-Software Picsart erstellt.